Hasta ahora era muy difícil reconstruir las imágenes que está viendo una persona a partir de los datos extraídos de un escáner fMRI, pero recientemente, un equipo de científicos chinos lo ha logrado utilizando un nuevo enfoque en el que recurren a una red neuronal.

Con este nuevo enfoque, la recuperación de las imágenes no solo es más sencilla, sino que se obtiene un resultado mucho más detallado que con los métodos anteriores.

La neurociencia lleva años tratando de reconstruir las imágenes que visualiza una persona analizando los datos captados con un escáner cerebral. El objetivo es averiguar qué está viendo esa persona monitorizando la actividad en su corteza visual.

No obstante, procesar las imágenes obtenidas de los escáneres fMRI no es una tarea sencilla, dado que en general contienen mucho ruido.

Además, es necesario convertir los voxel (datos tridimensionales) obtenidos por el escáner a píxeles para generar una imagen en dos dimensiones, por lo que hasta ahora los resultados obtenidos distaban bastante de los deseados.

Ahora, por fin, un equipo de tres científicos del Research Center for Brain-Inspired Intelligence de Pekín, en China, afirma haber desarrollado una técnica capaz de reconstruir las imágenes con una buena calidad de detalle utilizando algoritmos de aprendizaje profundo.

Para ello, utilizaron un conjunto de datos formado por 1.800 imágenes originales con sus respectivas imágenes procedentes de escáneres de fMRI.

Primero, entrenaron la red neuronal utilizando el 90% de dichas imágenes y, a continuación, utilizaron el 10% restante para probar el sistema.

En el proceso de entrenamiento la red debía aprender a identificar las correlaciones existentes entre la imagen original y la generada con un escáner de fMRI para, posteriormente, al proporcionarle una nueva imagen de escáner, ser capaz de generar una representación de la imagen original.

Lo más interesante y novedoso es que la red neuronal es capaz de identificar y reproducir las correlaciones existentes entre los voxels.

Esta información es fundamental para lograr una buena calidad de imagen y es, precisamente, lo que los sistemas desarrollados anteriormente, al parecer, no tenían en cuenta.

Los sistemas anteriores, al no contemplar las correlaciones, confundían toda esa información con ruido y la descartaban.

En cambio, el sistema desarrollado recientemente por los científicos chinos y denominado “deep generative multiview model” (DGMM) o modelo generativo multivista de arquitectura profunda distingue estas correlaciones del ruido real, logrando una reproducción mucho más detallada de la imagen original.

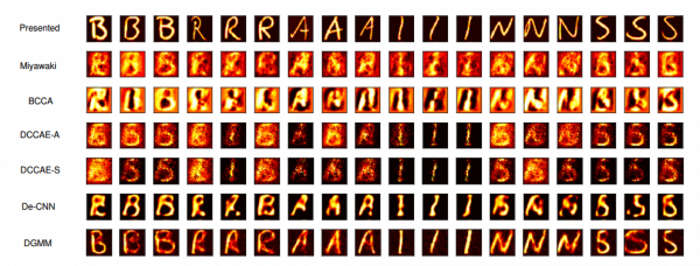

En un principio, los científicos utilizaron imágenes simples en las que la persona a la que se le realizaba el escáner estaba mirado solo una imagen de una cifra o una letra.

Una vez completado el estudio, los científicos compararon sus resultados con los obtenidos en estudios anteriores con otras técnicas y observaron que las imágenes obtenidas con esta nueva técnica coinciden, claramente, con la original y son mucho detalladas que las logradas hasta la fecha.

Comparación entre diferentes técnicas. La primera fila corresponde a las imágenes originales y a última a los resultados de la presente investigación.

Su trabajo podría ayudar en el desarrollo de mejores interfaces cerebro-máquina.

El siguiente paso será reproducir el estudio con imágenes más complejas e imágenes en movimiento.

Según Changde y sus colegas, se podría aplicar el mismo enfoque a otros tipos de información, como audio o tareas o movimientos físicos. Y, a la larga, incluso poder extraer una representación de lo que la persona está soñando o pensando.

Se puede consultar más información sobre el artículo, titulado “Sharing Deep Generative Representation for Perceived Image Reconstruction from Human Brain Activity” en Arxiv.org.

Fuente: Technology Review

Seguir leyendo:

- Desarrollan una IA capaz de imitar cualquier voz en menos de 1 minuto

- Adobe presenta una asombrosa herramienta de retoque digital con IA

- Un sistema de IA aprende por sí solo a reconocer el sentimiento

- Nadia, el nuevo asistente virtual con empatía y apariencia humana

- Kurzweil: la IA será inteligente en 2029 y nos fusionaremos con ella en 2045

Trackbacks/Pingbacks