A través de su blog oficial, Google ha dado a conocer una pequeña muestra de lo que su LLM (acrónimo del inglés Large Language Model) es capaz de hacer

PaLM ha sido entrenado utilizando una combinación del inglés y de un conjunto de datos multilingües que incluyen documentos de ‘alta calidad’. Entre algunos ejemplos de estos datos se encuentran libros, Wikipedia, conversaciones, o código de GitHub. Además, Google asegura que han creado para PaLM un vocabulario ‘sin pérdidas’, conservando todos los espacios en blanco para código, y dividiendo los caracteres Unicode que no se encuentran en el vocabulario en bytes.

Además de las tareas de PNL en inglés, PaLM también muestra un sólido desempeño en los puntos de referencia de PNL multilingüe, incluida la traducción, a pesar de que solo el 22 % del corpus de capacitación no está en inglés.

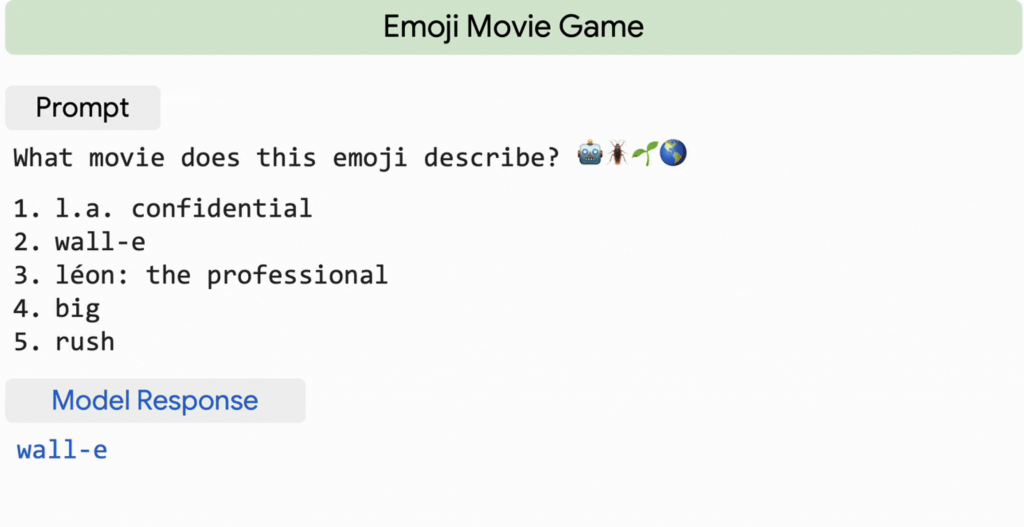

PaLM demuestra una impresionante comprensión del lenguaje natural y capacidades de generación en varias tareas de BIG-bench. Por ejemplo, el modelo puede distinguir causa y efecto, comprender combinaciones conceptuales en contextos apropiados e incluso adivinar la película a partir de un emoji.

PaLM muestra capacidades innovadoras en tareas de razonamiento que requieren aritmética de varios pasos o razonamiento de sentido común.

Sorprendentemente, PaLM puede incluso generar explicaciones explícitas para escenarios que requieren una combinación compleja de inferencia lógica de varios pasos, conocimiento del mundo y comprensión profunda del lenguaje. Por ejemplo, puede proporcionar explicaciones de alta calidad para chistes novedosos que no se encuentran en la web.

más información: https://ai.googleblog.com/2022/04/pathways-language-model-palm-scaling-to.html

40 hitos importantes de 1MillionBot en 2021

Trackbacks/Pingbacks