Los temores que rodean el desarrollo de la Inteligencia Artificial no son nada nuevo y han sido durante mucho tiempo la base de las tramas de ciencia ficción. Pero recientemente, una conversación entre un investigador y un chatbot en Google revitalizó la discusión sobre qué es la IA y cuándo y si algo puede llamarse “consciente”.

Esta es una explicación de lo que hace que incluso a un experto ha hecho dudar de si tiene o no “consciencia”:

Sundar Pichai, reveló en 2021 el “último avance en la comprensión del lenguaje natural” de la compañía, llamado LaMDA”.

En esencia, es básicamente un chatbot con tecnología de aprendizaje automático diseñado para hablar en general sobre cualquier tema, algo así como Watson de IBM cargado con una amplia gama de hechos, pero mejorado con una mejor comprensión del lenguaje y habilidades de generación de lenguaje. Google dijo en ese momento que había sido entrenado solo en texto, lo que significa que LaMDA no puede crear ni responder a cosas como imágenes, audio o video (aunque Google estaba planeando activamente expandir esas capacidades).

En ese momento, LaMDA era solo una curiosidad novedosa con una capacidad impresionante para analizar preguntas y generar respuestas sorprendentemente espontáneas que escapaban al ámbito de los hechos puros. Una demostración que hizo Google incluyó a LaMDA hablando desde la perspectiva del satélite solar degradado Plutón, aconsejando a alguien sobre cómo vestirse si le visita y cuándo fue la última vez que tuvo invitados, mientras hacía algún comentario sobre la falta de respeto que el planeta enano recibe. Como enfatizó Pichai en la presentación, este no es el tipo de chatbot que responde a una pregunta sobre el clima con un conjunto de números; tiene un poco más de estilo o perspectiva y es más capaz de modelar cómo usamos realmente el lenguaje.

Otro gran beneficio de LaMDA es que es un modelo único que no necesita volver a capacitarse para diferentes conversaciones o temas. Es lo que se llama un modelo de “dominio abierto”. Eso significa que LaMDA-as-Pluto es la misma LaMDA que puede responder preguntas sobre la historia o el clima. Pero incluso esta primera versión de LaMDA tenía inconvenientes. Algunas de sus respuestas bordeaban el absurdo. Como ejemplo, una pregunta sobre la gravedad en Plutón hizo que respondiera sobre saltar alto y practicar sus volteretas (Plutón saltando sobre Plutón) o jugando a buscar con la luna.

En Google I/O en 2022, Google reveló “LaMDA 2“, una versión más avanzada de la IA conversacional. Esta vez, Google permitió que “miles de Googlers” lo probaran, parte para reducir los casos de respuestas problemáticas u ofensivas. LaMDA 2, según todas las apariencias, tiene muchas de las mismas características y funcionalidades que el original, y funciona como un sofisticado chatbot de propósito general. Sin embargo, la demostración de Google en ese momento fue más enfocada, señalando demostraciones técnicas como mantener una conversación sobre el tema, generar listas vinculadas a un tema o imaginar estar en un lugar específico. Las habilidades de LaMDA ciertamente no se limitan a estos flujos de trabajo, son solo una vía que Google quiere tomar para probar y perfeccionar el funcionamiento de LaMDA.

LaMDA ni siquiera es el modelo de procesamiento de lenguaje más sofisticado de Google. PaLM (también presentado en I/O) es un sistema aún más grande y sofisticado que puede manejar problemas que LaMDA no puede, como la generación de código y matemáticas, con un sistema de procesamiento más avanzado que demuestra su trabajo para una mayor precisión.

LaMDA se basa en una especie de arquitectura neuronal llamada Transformer que Google ayudó a diseñar en 2017. Esto se vuelve complejo rápidamente, pero Transformer básicamente ofrece una ventaja tanto en el rendimiento del entrenamiento (el tiempo para construir el modelo) como en la precisión resultante (lo bueno que es) en comparación con los modelos neuronales recurrentes y convolucionales (los sistemas de aprendizaje automático más típicos de los últimos años de la adolescencia) en lo que respecta al procesamiento del lenguaje.

En lugar de confiar en un análisis paso a paso de la entrada de texto, Transformer analiza oraciones completas simultáneamente y puede modelar las relaciones entre ellas para comprender mejor un significado contextualmente matizado. Y dado que hace un análisis general como este de una sola vez, necesita menos pasos para hacer su trabajo: cuantos menos pasos haya en un modelo de aprendizaje automático, más probable es que pueda entrenarse para que haga bien su trabajo.

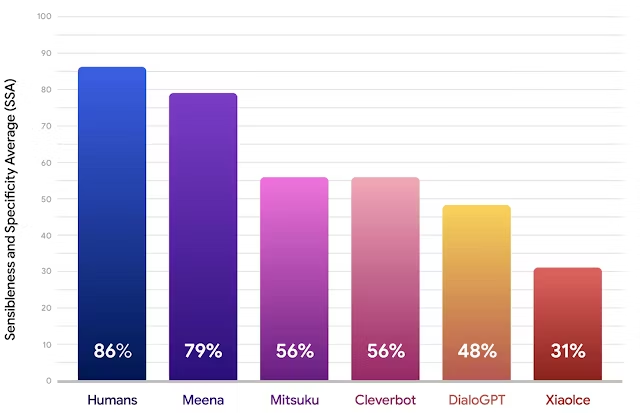

En el caso de Meena, nadie se apresuró a decir que podía tener “consciencia” aunque sus conversaciones fueran muy brillantes y se acercaran bastante a las de un humanos según las métricas de Google.

El “promedio de sensatez y especificidad” no es un estándar generalizado, sino una métrica que los ingenieros de Google usaron para medir el éxito de Meena en función de dos preguntas simples: ¿Es una respuesta específica y tiene sentido?

Y LaMDA ni siquiera es el final aquí. Como se mencionó anteriormente, el nuevo y brillante sistema PaLM de Google tiene capacidades que LaMDA no puede abordar, como la capacidad de probar su trabajo, escribir código, resolver problemas matemáticos basados en texto e incluso explicar chistes, con un parámetro “cerebro” que es casi cuatro veces más grande!. Además de eso, PaLM adquirió la capacidad de traducir y responder preguntas sin recibir capacitación específica para la tarea: el modelo es tan grande y sofisticado que la presencia de información relacionada en el conjunto de datos de capacitación fue suficiente.

Más información: https://www.androidpolice.com/what-is-google-lamda/

14 proyectos y logros de 1MillionBot en los últimos tres meses

14 proyectos y logros de 1MillionBot en los últimos tres meses

No entendía bien que estaba pasando, muchas gracias por el trabajo.