Investigadores de la Universidad Carnegie Mellon han conseguido leer pensamientos complejos en imágenes de resonancias magnéticas.

Los resultados de la investigación indican que las piezas mentales utilizadas para construir pensamientos complejos están formadas por varios subsistemas del cerebro y no están basadas en palabras.

Publicado en Human Brain Mapping y financiado por la IARPA (Intelligence Advanced Research Projects Activity), el estudio ofrece nuevas pruebas de que las dimensiones neuronales de la representación de conceptos son universales en todas las personas e idiomas.

Los científicos llevan años tratando de desarrollar algún sistema que les permita leer la mente.

Ahora, por fin, haciendo un uso pionero de los algoritmos de aprendizaje automático y las tecnologías de imágenes cerebrales desarrollados para tal fin, un equipo de investigadores de la Carnegie Mellon ha logrado identificar pensamientos complejos en imágenes de resonancias magnéticas del cerebro, analizando los patrones de activación cerebral observados en diversos estudios.

En estudios anteriores, Just y su equipo mostraron que los pensamientos de objetos familiares, como plátanos o martillos, evocaban patrones de activación en los sistemas neuronales que utilizamos para interactuar con dichos objetos. Por ejemplo, en el caso de un plátano: cómo lo sostenemos, cómo lo mordemos y cuál es su aspecto.

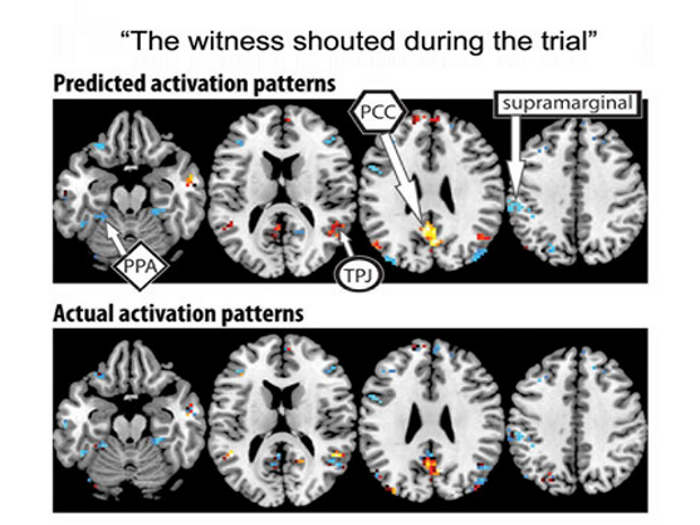

El nuevo estudio demuestra que la codificación en el cerebro de 240 eventos y oraciones complejas utiliza un alfabeto de 42 componentes de significado o características semánticas, entre ellas, la persona, el entorno, el tamaño, la interacción social o la acción física.

Cada tipo de información se procesa en un sistema diferente del cerebro, de manera similar a como el cerebro procesa la información de los objetos. Midiendo la activación en cada sistema del cerebro de una persona, el programa puede decir qué tipos de pensamientos está contemplando.

En el estudio, en el que participaron 7 personas adultas, los investigadores utilizaron un modelo computacional para evaluar la correspondencia entre los patrones de activación del cerebro para 239 oraciones y las características semánticas de cada oración.

El programa fue capaz de decodificar las características de cada una de las oraciones. A continuación, se evaluaron las oraciones de una en una, en lo que se conoce como validación cruzada.

El modelo fue capaz de predecir las características de cada una de las oraciones con un 87% de precisión, a pesar de no haber sido expuesto antes a su activación.

E incluso fue capaz de realizar la operación inversa, es decir, predecir el patrón de activación de una oración no vista previamente, conociendo sólo sus características semánticas.

“Nuestro método resuelve la desafortunada propiedad de la fMRI de difuminar las señales que emanan de eventos cerebrales que suceden juntos en el tiempo, como la lectura de dos palabras sucesivas en una frase”, señaló Just. “Este avance hace posible por primera vez descodificar pensamientos que contienen varios conceptos. Y de eso se componen la mayoría de los pensamientos humanos”.

“Un siguiente paso podría ser descodificar el tipo general de tema en el que está pensando una persona, como la geología o el skateboard. Estamos en camino de hacer un mapa de todos los tipos de conocimiento en el cerebro“.

Fuente:

Seguir leyendo:

- Un detector de mentiras con inteligencia artificial para mejorar la seguridad en los aeropuertos

- Nueva IA capaz de predecir cuándo y cómo vamos a morir

- Científicos chinos logran reconstruir lo que está viendo una persona utilizando un escáner cerebral

- Dos chatbots sorprenden a Facebook al inventar un nuevo lenguaje sin intervención humana

Trackbacks/Pingbacks