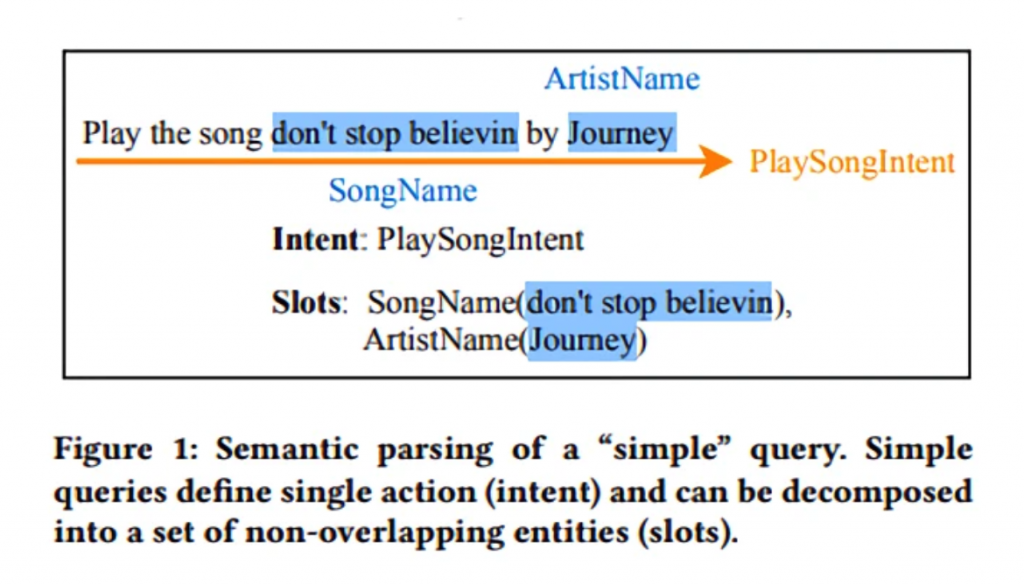

Los asistentes de voz normalmente se basan en un componente de análisis semántico para que comprenden qué acciones tiene que ejecutar para un comando de voz. Tradicionalmente, los sistemas estaban basados en reglas que se utilizaban para analizar consultas simples, es decir, de una acción. Actualmente, se han propuesto analizadores de reducción de turnos para procesar enunciados más complejos. Pero estos métodos tienen limitaciones en el tipo de consultas que pueden analizar porque requieren que las consultas sean representables cómo árboles de análisis.

Es por esto que los investigadores de Amazon propusieron una arquitectura unificada para manejar consultas simples y complejas. Afirman que, a diferencia de otros enfoques, el suyo carece de restricciones en el análisis semántico. Afirman que ha logrado un rendimiento de vanguardia en conjunto de datos disponibles públicamente, con mejoras entre el 3,3% y el 7,7% en la precisión de acierto con respecto a los sistemas anteriores.

Una parte importante de cualquier asistente de voz es un componente de análisis semántico que comprenda la acción que solicitan los usuarios. A pesar de los grandes avances en el campo del procesamiento del lenguaje natural, esta tarea sigue siendo difícil debido a la gran cantidad de combinaciones possibles que un usuario puede pedir una misma cosa. Con las crecientes expectativas que tienen los usuarios de los asistentes conversacionales, hay una gran necesidad de mejorar los sistemas para que manejen consultas más complejas.

Fuente: Venturebeat

El equipo probó el nuevo enfoque con cinco conjuntos de datos diferentes: tres disponibles públicamente y dos internos. Entre los corpus públicos estaban el análisis orientado a tareas de Facebook, que contiene consultas jerárquicas y complejas que hacen que la tarea del análisis semántico sea más desafiante. SNIPS, que se usa para entrenar y evaluar modelos de análisis semántico para asistentes de voz y ATIS, un popular conjunto de datos de comprensión de idiomas. Internamente, el equipo aisló colecciones de los millones de frases que utilizan para entrenar y probar Amazon Alexa, específicamente, uno del dominio de la música con 6,2 millones de entrenamiento y 200.000 frases de prueba y uno del dominio de vídeo con 1 millón de entrenamientos y 5.000 frases para probar

Después de entrenar el sistema con ocho tarjetas gráficas Nvidia Tesla V100, cada una con 16GB de memoria, los investigadores dicen que lograron una mejora de precisión del 3.3% en el conjunto de datos TOP.

En los conjuntos de datos SNIPS y ATIS, mejoró la precisión sobre las líneas de base existentes, 7.7% y 4.5%, respectivamente, y en el corpus de emisión de música interna en 1.9%.

Fuente: Venturebeat