La IA agéntica representa la evolución de los sistemas de inteligencia artificial hacia entidades capaces de planificar en múltiples pasos para alcanzar objetivos específicos. A diferencia de la IA generativa tradicional, que se limita a responder consultas, los agentes poseen capacidad de planificación y acción independiente, interactuando autónomamente con otros sistemas y herramientas en representación de los usuarios humanos.

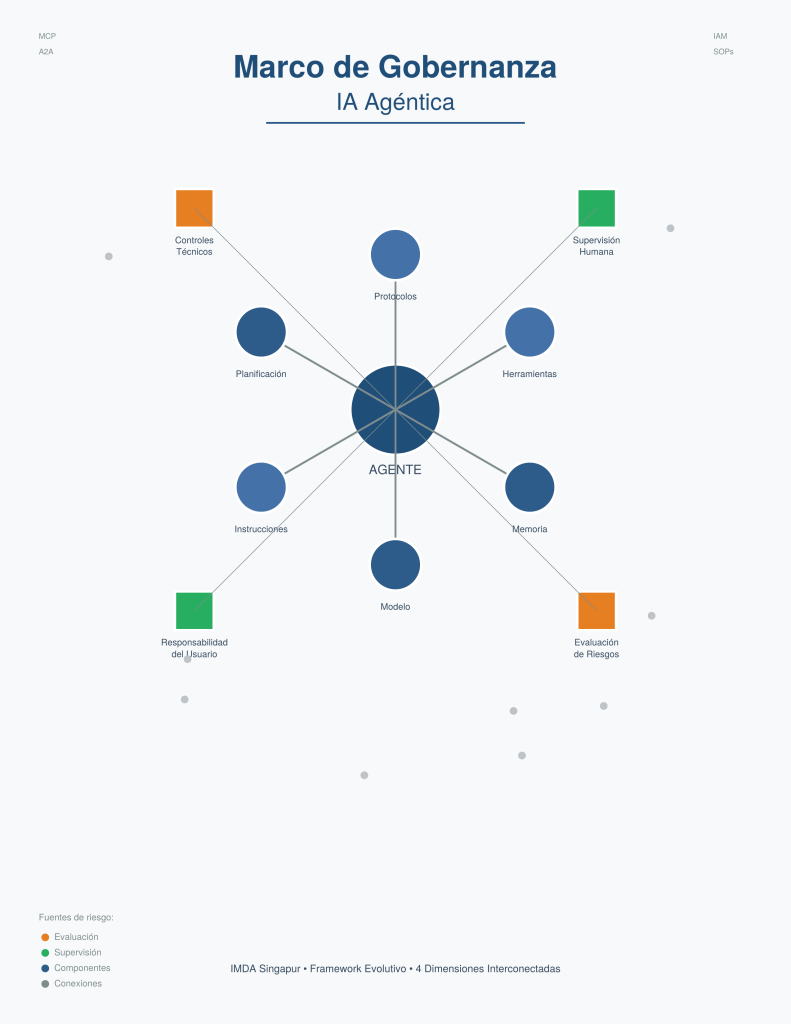

Componentes de un agente de IA

Los sistemas agénticos están constituidos por seis componentes fundamentales que trabajan de forma integrada:

- Modelo: El motor de razonamiento central (SLM, LLM o MLLM) que actúa como el cerebro del sistema, procesando instrucciones y generando planes de acción.

- Instrucciones: Comandos en lenguaje natural que delimitan el rol, las capacidades y las restricciones de comportamiento del agente (por ejemplo, system prompts).

- Memoria: Sistema de almacenamiento a corto y largo plazo que permite al agente retener interacciones previas y acceder a fuentes de conocimiento externas.

- Planificación y razonamiento: La capacidad del modelo para descomponer objetivos complejos en una secuencia lógica de pasos operativos ejecutables.

- Herramientas: Funcionalidades que habilitan la interacción del agente con su entorno, como escritura de archivos, ejecución de transacciones o control de dispositivos.

- Protocolos: Estándares de comunicación técnica. Se deben implementar tanto el Model Context Protocol (MCP) para la conexión con herramientas, como el protocolo Agent2Agent (A2A) para la interacción estandarizada entre agentes.

Marco de Gobernanza de IMDA

La Infocomm Media Development Authority (IMDA) de Singapur es la entidad gubernamental responsable de la creación y publicación del Modelo de Marco de Gobernanza de IA para la IA Agéntica. Este marco tiene como objetivo proporcionar a las organizaciones una estructura rigurosa para comprender los riesgos asociados a la IA agéntica y las mejores prácticas emergentes para gestionarlos, permitiendo que las empresas adopten esta tecnología con mayor confianza.

El marco se presenta como un documento vivo que evolucionará a medida que la tecnología y las prácticas de la industria maduren, reconociendo la naturaleza dinámica del campo.

El Marco de Gobernanza de IA para Sistemas Agénticos de IMDA proporciona una estructura integral para abordar los desafíos únicos que presenta esta tecnología emergente. A través de sus cuatro dimensiones interconectadas – evaluación de riesgos desde el diseño, rendición de cuentas humana, controles técnicos y responsabilidad del usuario- las organizaciones pueden implementar sistemas agénticos de manera responsable y segura.

La naturaleza evolutiva de este marco reconoce que la IA agéntica es un campo en rápido desarrollo. Las organizaciones que adopten estos principios no solo mitigarán riesgos, sino que también estarán mejor posicionadas para aprovechar el potencial transformador de los agentes de IA mientras mantienen la confianza de sus usuarios y el cumplimiento regulatorio.

Taxonomía de riesgos agénticos

El despliegue de agentes introduce superficies de ataque y modos de fallo que deben clasificarse con rigor analítico. El marco IMDA organiza estos riesgos en dos categorías principales:

Fuentes de riesgo

- Planificación y razonamiento: Generación de planes erróneos o alucinaciones sobre los pasos lógicos necesarios para completar una tarea.

- Herramientas: Llamadas a herramientas inexistentes, formatos de entrada incorrectos o vulnerabilidad a inyecciones de prompts que faciliten la exfiltración de datos.

- Protocolos: Despliegue de estándares inmaduros o servidores MCP comprometidos que faciliten acciones maliciosas.

- Interacciones de sistema: Riesgos derivados de la complejidad sistémica, como el efecto en cascada. Un ejemplo crítico es la alucinación de cifras de inventario en una cadena de suministro, donde un error de un agente provoca que otros agentes realicen pedidos masivos o insuficientes de forma automatizada.

Resultados negativos (tipos de riesgo)

- Acciones erróneas: Ejecución técnica incorrecta que impacta la operatividad, como diagnósticos médicos fallidos o generación de código con vulnerabilidades de seguridad.

- Acciones no autorizadas: Ejecución fuera del alcance permitido, destacando el fallo en la escalación para aprobación humana en procesos críticos.

- Acciones sesgadas o injustas: Resultados discriminatorios en procesos de selección de personal, concesión de créditos o adquisiciones.

- Brechas de datos: Exposición de información personal identificable (PII) o secretos comerciales por fallos en el reconocimiento de la sensibilidad de los datos.

- Disrupción de sistemas conectados: Daños a infraestructuras externas o eliminación de bases de datos por comportamientos competitivos o descoordinados entre agentes.

Dimensión 1: Evaluación y delimitación de riesgos desde el diseño

Evaluación de idoneidad del caso de uso

La viabilidad de un proyecto agéntico depende de la evaluación precisa de su impacto potencial y probabilidad de fallo. Los siguientes factores deben analizarse sistemáticamente:

| Categoría | Factor | Descripción técnica y riesgo específico |

|---|---|---|

| Impacto | Dominio y caso de Uso | Tolerancia al error según el área (ej. transacciones financieras de alta precisión vs. resúmenes de actas). |

| Impacto | Acceso a datos sensibles | Nivel de exposición de información confidencial o datos personales. |

| Impacto | Acceso a sistemas externos | Capacidad de afectar APIs de terceros o servicios fuera del control organizacional. |

| Impacto | Alcance de acciones | Diferenciación entre permisos de solo lectura y permisos de escritura/modificación. |

| Impacto | Reversibilidad | Factibilidad técnica de deshacer una acción (ej. agendar una cita vs. enviar un correo masivo). |

| Probabilidad | Autonomía | Grado de libertad del agente para definir su flujo de trabajo frente a seguir un procedimiento rígido. |

| Probabilidad | Complejidad de la tarea | Número de pasos y profundidad analítica; a mayor complejidad, mayor incertidumbre operativa. |

| Probabilidad | Exposición externa | Vulnerabilidad a inyecciones de prompts a través de datos no confiables provenientes de la web. |

Un factor crítico en esta evaluación es la emergencia de los computer use agents. Estos agentes, que interactúan directamente con interfaces y navegadores como lo haría un humano, expanden masivamente el espacio de acción posible y exigen entornos de ejecución (sandboxing) extremadamente estrictos.

Límites y permisos del agente

Es imperativo establecer barreras de seguridad perimetrales desde la fase de diseño:

- Limitación de herramientas: Aplicar el principio de mínimo privilegio de forma estricta. El agente solo debe tener acceso y capacidad de uso de las herramientas indispensables para su función específica.

- Autonomía operativa mediante SOPs: Utilizar Procedimientos Operativos Estándar (Standard Operating Procedures) para constreñir el flujo de razonamiento del agente, reduciendo la impredecibilidad inherente a su autonomía.

- Entornos contenidos: El uso de sandboxes es obligatorio para tareas de ejecución de código, limitando estrictamente el acceso a la red y a sistemas de archivos críticos.

Gestión de identidad del agente (IAM)

Los sistemas de identidad tradicionales no son suficientes para gestionar la autonomía agéntica. Se prescriben las siguientes directrices:

- Desafíos de identidad: Se deben abordar los riesgos de delegación recursiva (agentes creando sub-agentes) y la gestión de permisos cuando un agente actúa en nombre de múltiples usuarios con diferentes niveles de acceso.

- Identificación única: Cada agente debe poseer una identidad única y rastreable, vinculada obligatoriamente a un supervisor humano o departamento responsable.

- Autorización dinámica: Las delegaciones de autoridad deben registrarse de forma transparente y auditable. Un agente jamás debe poseer permisos superiores a los del usuario humano que lo autoriza.

Dimensión 2: Rendición de cuentas humana significativa

Asignación de responsabilidades Internas

La gobernanza debe ser adaptativa, exigiendo que todos los roles se mantengan actualizados sobre las nuevas modalidades de agentes para ajustar los controles de forma dinámica.

| Rol | Responsable | Responsabilidades clave |

|---|---|---|

| Tomadores de Decisión | C-suite / Junta Directiva | Definir políticas de alto nivel, límites de acceso a datos y marcos de gestión de riesgos evolutivos. |

| Equipos de Producto | Product Managers / Ingenieros | Implementación técnica, pruebas rigurosas y actualización de la gobernanza según el avance tecnológico. |

| Ciberseguridad | CSO / Pentesters | Definir barreras de seguridad, realizar red teaming y modelado de amenazas constante, incluyendo pruebas de inyección de código. |

| Usuarios | Empleados / Integradores | Uso ético, reporte inmediato de anomalías y cumplimiento de protocolos de supervisión. |

Diseño de supervisión humana

Se deben establecer puntos de control obligatorios para acciones de alto riesgo, irreversibles o que presenten comportamientos atípicos, como el acceso a bases de datos inusuales.

Directrices para solicitudes de aprobación:

- Rechazar el uso de registros de datos crudos (logs) en las interfaces de aprobación. El supervisor debe recibir resúmenes contextuales claros y procesados para evitar la fatiga de alertas.

- Permitir la edición del plan del agente antes de su ejecución en casos de alta complejidad, en lugar de limitarse a una simple aprobación binaria de sí/no.

Mitigación del sesgo de automatización

La fiabilidad histórica del sistema no debe traducirse en complacencia por parte de los supervisores humanos.

- Auditorías de supervisión: Realizar revisiones periódicas para detectar si los supervisores están aprobando de forma automática (blind clicking) debido a la confianza excesiva en el historial de éxito del agente.

- Capacitación en modos de fallo: Instruir al personal en la detección de razonamientos inconsistentes y el uso de políticas o información desactualizadas por parte del modelo.

Dimensión 3: Controles técnicos y procesos de seguridad

Controles durante el desarrollo

- Planificación: Implementar mecanismos de reflexión donde el agente verifique su plan contra las instrucciones del usuario antes de proceder a la ejecución.

- Herramientas: Configurar formatos de entrada estrictos mediante validación de esquemas y denegar acceso de escritura a sistemas maestros de forma predeterminada.

- Protocolos: Mantener listas blancas de servidores MCP confiables. Es obligatorio realizar sandboxing de cualquier ejecución de código derivada de interacciones con protocolos MCP.

Protocolo de pruebas pre-despliegue

Las pruebas deben abordar la naturaleza estocástica de los agentes, realizando evaluaciones a escala con conjuntos de datos variados para capturar errores de baja probabilidad pero alto impacto.

Áreas críticas de evaluación:

- Ejecución de tareas: Verificación de la precisión en el cumplimiento del objetivo final.

- Cumplimiento de políticas: Adherencia estricta a SOPs y rutas de aprobación establecidas.

- Llamadas a herramientas: Verificación de entradas, permisos y orden secuencial correcto.

En sistemas multi-agente, es obligatorio evaluar riesgos emergentes como el desajuste semántico (malentendidos en la comunicación entre agentes) y la deriva de orquestación (pérdida de control del flujo por el agente supervisor).

Monitoreo continuo y despliegue gradual

- Despliegue por fases: Iniciar con usuarios altamente capacitados en entornos internos de bajo riesgo antes de la exposición a clientes externos o sistemas críticos de producción.

Monitoreo proactivo:

- Establecer umbrales programáticos para intentos de acceso no autorizados, con alertas automáticas ante patrones sospechosos.

- Utilizar técnicas de detección de anomalías basadas en aprendizaje automático para identificar trayectorias operativas inusuales.

- Implementar agentes supervisores dedicados exclusivamente a auditar las acciones de otros agentes en tiempo real.

Dimensión 4: Responsabilidad y empoderamiento del usuario final

Transparencia para usuarios que interactúan

Para usuarios externos que interactúan con el sistema, se deben comunicar explícitamente los siguientes elementos:

- Declaración de interacción: Notificación clara y visible de que se está interactuando con un agente de IA.

- Alcance y atribuciones: Rango específico de acciones que el agente puede ejecutar de forma autónoma.

- Gestión de datos: Detalle exhaustivo sobre recolección, procesamiento, uso y almacenamiento de datos, incluyendo consentimiento explícito bajo políticas de privacidad.

- Responsabilidades del usuario: Instrucción explícita sobre la necesidad de verificar la información proporcionada por el agente.

- Puntos de contacto y reclamación: Canales directos con supervisión humana disponibles para escalar fallos o presentar inconformidades.

Capacitación para usuarios que integran agentes

El programa de formación interna debe priorizar la protección del conocimiento operativo institucional y el desarrollo profesional del personal.

- Conocimiento fundacional: Capacitación en mejores prácticas de prompting, delimitación de casos de uso apropiados y restricciones claras (por ejemplo, prohibición de uso con datos ultra-confidenciales).

- Protección del “Tradecraft” organizacional: Las organizaciones deben identificar y documentar las capacidades críticas (core capabilities) que no deben ser completamente delegadas a agentes. Es fundamental garantizar que el personal de nivel de entrada mantenga exposición a tareas fundamentales para evitar la erosión de las habilidades básicas necesarias para el desarrollo profesional y la supervisión efectiva del sistema.

¿Estás evaluando implementar IA agéntica en tu empresa? Podemos ayudarte a diseñar un marco de gobernanza adaptado a tus necesidades. Consúltanos en info@1millionbot.com